Wichtig: Dieser Artikel und die beschriebene App stellen keine Rechtsberatung dar und sind nicht rechtlich bindend. Die Informationen dienen ausschließlich der allgemeinen Orientierung und zur Unterstützung bei der ersten, unverbindlichen Risikoeinschätzung.

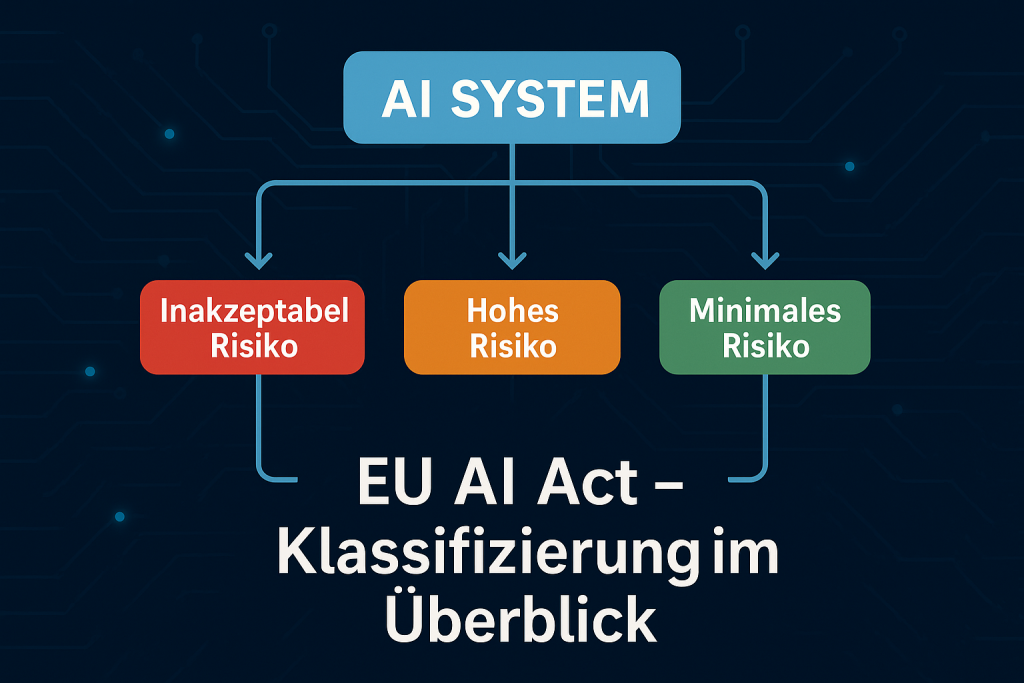

Die KI-Verordnung (EU AI Act) bringt tiefgreifende Veränderungen für alle Unternehmen mit, die Künstliche Intelligenz entwickeln oder einsetzen. Das Gesetz nutzt einen risikobasierten Ansatz, der KI-Systeme in vier Risikoklassen einteilt – von “minimal” bis “inakzeptabel” [1].

Die korrekte Klassifizierung eines spezifischen KI-Systems ist von entscheidender Bedeutung. Sie bestimmt, welche umfassenden Compliance-Anforderungen erfüllt werden müssen und ob die Anwendung möglicherweise sogar untersagt ist.

Der nachfolgende Text erläutert die Überführung der komplexen Regelungen des AI Acts in einen praktischen Entscheidungsbaum. Darauf aufbauend wurde eine Webanwendung entwickelt, welche eine komfortable Ersteinschätzung der Risikoklasse ermöglicht.

Recherche und Erstellung eines Entscheidungsbaums

Um eine verlässliche Klassifizierung zu ermöglichen, musste die gesetzliche Logik, die in verschiedenen Artikeln und Anhängen beschrieben ist, in einen klaren, schrittweisen Ablauf gebracht werden.

Dabei beginnt jede Prüfung mit der strengsten Kategorie (Verbot) und wird bis zur niedrigsten Kategorie fortgesetzt.

Der dreistufige Rechercheprozess zur Logik

- Regelwerks-Hierarchie (Die 4 Kategorien): Zuerst wurden die vier Risikostufen klar definiert: Inakzeptables Risiko (Verbot), Hohes Risiko, Begrenztes Risiko (Transparenz) und Minimales Risiko.

- Abgrenzungskriterien (Anhang I & III): Es wurden die Listen der Systeme identifiziert, die automatisch zu einer Hochrisiko-KI werden (Anhang I: Sicherheitskomponenten; Anhang III: kritische Einsatzbereiche). Diese Listen dienen als primäre JA/NEIN-Entscheidungspunkte.

- Grenzfälle und Ausnahmen (Art. 6 Abs. 3): Dies war der schwierigste Teil. Es wurde die gesetzliche Bestimmung recherchiert, die vorsieht, dass ein System aus dem Hochrisikobereich dennoch nicht als Hochrisiko-KI gilt, wenn es nur unterstützend oder vorbereitend eingesetzt wird und die menschliche Kontrolle uneingeschränkt möglich ist. Dieses Kriterium war der Schlüssel zur Unterscheidung zwischen einem reinen “Werkzeug” und einem “Entscheidungsträger”.

Der finale Entscheidungsbaum zur Klassifizierung

Der daraus abgeleitete Entscheidungsbaum, der auch die Logik des digitalen Assistenten bildet, umfasst 5 Hauptfragen und führt zuverlässig zum Ergebnis.

| Schritt | Frage | Ergebnis bei “JA” |

|---|---|---|

| Schritt 0 | Ist mein System überhaupt eine KI im Sinne des AI Acts (vgl. Anhang I, Liste der KI-Techniken). | Weiter zu Schritt 1 |

| Schritt 1 | Führt das System eine verbotene Praxis durch (z. B. Social Scoring, schädliche Manipulation)? | Inakzeptables Risiko (Verboten) |

| Schritt 2A | Ist es ein Sicherheitsbauteil eines Produkts (Anhang II, Produktsicherheit), das einer Konformitätsbewertung unterliegt (z. B. Medizingerät)? | Hohes Risiko |

| Schritt 2B | Wird es in einem der kritischen Anhang III-Bereiche eingesetzt (z. B. Personalwesen, Kreditwürdigkeitsprüfung)? | Weiter zu Schritt 2C (Ausnahme) |

| Schritt 2C (Grenzfall) | Dient es in diesem Anhang III-Bereich nur als unterstützendes Werkzeug, ohne die finale menschliche Entscheidung wesentlich zu beeinflussen? | Nein: Hohes Risiko (Es trifft die wesentliche Entscheidung) |

| Schritt 3 | Unterliegt das System einer Transparenzpflicht (z. B. es ist ein Chatbot oder ein Deepfake-Generator)? | Begrenztes Risiko |

| Schritt 4 | Fällt es in keine der oberen Kategorien? | Minimales Risiko |

Entwicklung der App – Der Klassifizierungs-Assistent

Es bot sich an, diesen Entscheidungsbaum in eine responsive Web-App zu übersetzen, da es dem Anwender eine komfortable Möglichkeit bietet, die Einhaltung des AI Acts besser bewerten zu können.

Technische Umsetzung

Die gesamte Logik wurde in einer einzigen HTML-Datei mithilfe von Tailwind CSS für das Design und JavaScript für die Entscheidungslogik umgesetzt.

Die Antworten des Anwenders werden in einer Historie zwischengespeichert, die als Grundlage für die Ergebnisdokumentation dient. Eine “Zurück”-Schaltfläche, die die Navigation durch den Fragenkatalog verbessert, greift ebenfalls auf die Historie zurück. Das Ergebnis kann am Ende auch als PDF-Dokument exportiert werden.

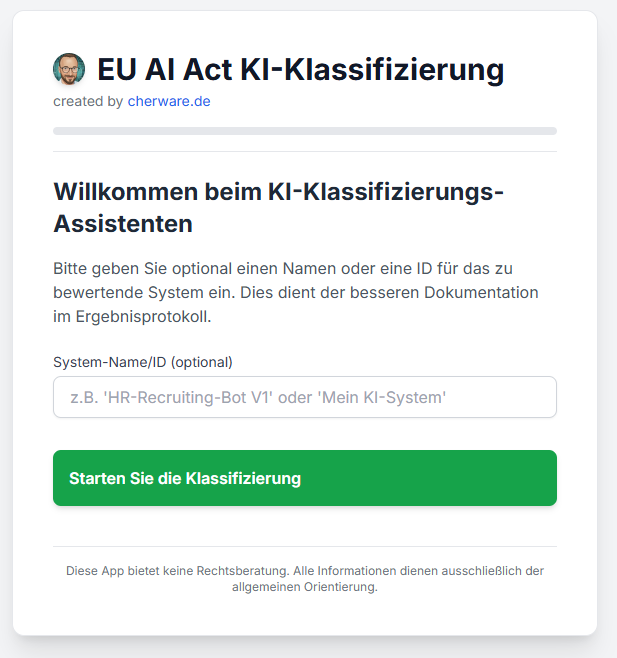

Tutorial: So funktioniert der Klassifizierungs-Assistent

Der Web-App-Assistent führt den Anwender intuitiv durch die Fragen, wobei jeder Schritt eine detaillierte Erläuterung der gesetzlichen Bestimmungen liefert.

1. System-ID eingeben (Start):

Der Anwender gibt optional den Namen oder die ID des Systems ein. Dieser Name wird in allen Fragen und im finalen PDF-Protokoll verwendet.

2. Abarbeitung des Entscheidungsbaums:

Der Assistent beginnt mit der Prüfung auf Verbot. Bei jeder “Nein”-Antwort rückt das System zur nächstniedrigeren Risikokategorie vor. Die Erklärtexte helfen dabei, die juristischen Begriffe zu erläutern.

3. Behandlung des Hochrisiko-Grenzfalls (Schritt 2C):

Wenn ein System in einem kritischen Bereich (Anhang III) eingesetzt wird, fragt das Tool explizit nach der Rolle der KI. Dies ist die Prüfung des Art. 6 Abs. 3, die den entscheidenden Unterschied macht. Nur wenn die KI die finale menschliche Entscheidung wesentlich beeinflusst oder maßgeblich trifft, gilt das System als Hochrisiko-KI. Die menschliche Kontrolle über die finale Entscheidung muss jederzeit uneingeschränkt möglich und tatsächlich gegeben sein. Bei einer rein vorbereitenden Rolle führt der Weg weiter zum Begrenzten Risiko.

4. Ergebnis und Dokumentation:

Am Ende erhält der Anwender eine klare Einstufung. Die Schaltfläche “Als PDF speichern” generiert automatisch ein Protokoll, das alle gewählten Antworten, die finale Risikoklasse sowie die wichtigsten Compliance-Implikationen enthält.

Zusammenfassung und Fazit

Die korrekte Einstufung eines KI-Systems ist der zentrale und schwierigste Schritt zur EU AI Act Compliance. Entscheidend ist der Anwendungskontext: Eine Einstufung als Hochrisiko-KI erfolgt nur, wenn das System in den kritischen Anhängen (I oder III) eine maßgeblich entscheidende Funktion übernimmt. Dient die KI lediglich als unterstützendes oder vorbereitendes Werkzeug, gelten oft geringere Anforderungen.

Der Klassifizierungs-Assistent übersetzt diese risikobasierte Logik in einen praktikablen Entscheidungsbaum zur schnellen Erstbewertung und Dokumentation.

Wichtig: Dieses Tool dient der Orientierung und ersetzt nicht die nachfolgende, detaillierte technische Konformitätsbewertung oder eine Rechtsberatung.

Ausblick: Von der Ersteinschätzung zur belastbaren Klassifizierung

Die hier vorgestellte Klassifizierung bietet eine erste Orientierung, wie ein KI-System nach dem EU AI Act eingeordnet werden kann. In der Praxis reicht diese Grobeinstufung jedoch noch nicht aus, um die Einstufung gegenüber Aufsichtsbehörden oder Geschäftspartnern belastbar zu begründen.

In einem nächsten Schritt geht es daher darum, die Klassifizierung zu vertiefen und zu dokumentieren. Dabei stehen insbesondere folgende Fragen im Mittelpunkt:

- Präzisierung des Einsatzkontextes: Wie genau wird das KI-System eingesetzt, und welche Funktion erfüllt es im Entscheidungsprozess? Entscheidend ist, ob das System eine menschliche Entscheidung ersetzt, beeinflusst oder lediglich vorbereitet. Diese Unterscheidung entscheidet oft, ob ein System tatsächlich als Hochrisiko gilt oder nicht.

- Abgrenzung der rechtlichen Grundlagen: Welche Regelungen des EU AI Act greifen konkret? Hierzu gehört die Prüfung, ob das System unter Anhang I (harmonisierte Produkte) oder Anhang III (bestimmte Einsatzbereiche) fällt – und ob Ausnahmen nach Artikel 6 (3) greifen.

- Dokumentation der Risikoeinschätzung: Eine nachvollziehbare Begründung, warum ein System als Hochrisiko oder Nicht-Hochrisiko eingestuft wird, ist künftig Pflicht. Unternehmen sollten daher frühzeitig festhalten, welche Kriterien, Annahmen und Grenzen der Klassifizierung zugrunde liegen.

- Überprüfung im Lebenszyklus: Klassifizierungen sind keine einmalige Aufgabe. Änderungen an Funktionen, Trainingsdaten oder Einsatzkontext können zu einer Neubewertung führen. Ein internes Verfahren zur regelmäßigen Überprüfung sollte daher Teil des KI-Managements sein.

- Abgrenzung zu weiteren Pflichten: Sobald klar ist, dass ein System als Hochrisiko gilt, schließen sich Folgepflichten an – etwa zu Datenqualität, technischer Dokumentation, Risiko- und Qualitätsmanagement oder menschlicher Aufsicht. Diese Themen können Gegenstand eines weiteren Beitrags sein, der aufzeigt, wie aus einer Erstklassifizierung eine vollständige Compliance-Bewertung wird

Weblinks

- EU AI Act Risikoklassifizierung (Die App zur Klassifizierung eines Systems)

References

- (2025): Der EU AI Act: Was die neue KI-Verordnung für Unternehmen bedeutet. 2025, visited: 19.01.2025.